| (4 intermediate revisions by the same user not shown) | |||

| Line 25: | Line 25: | ||

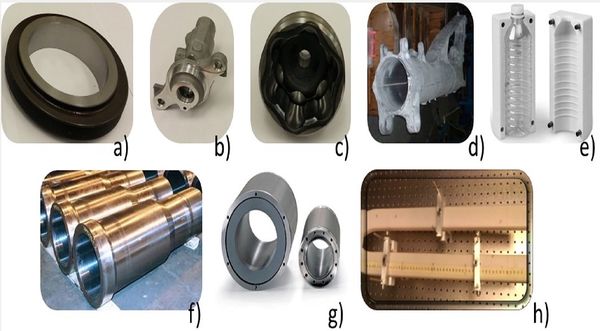

mencionar la medición del interior del cilindro maestro que forma parte del sistema de frenado de los autos, el escaneo 3D del | mencionar la medición del interior del cilindro maestro que forma parte del sistema de frenado de los autos, el escaneo 3D del | ||

interior del cuerpo humano, la medición en el interior de tuberías, la medición del interior de botellas hechas de plástico, entre | interior del cuerpo humano, la medición en el interior de tuberías, la medición del interior de botellas hechas de plástico, entre | ||

| − | otros (Figura 1). El presente trabajo propone el uso de un sistema de medición capaz de obtener la posición de la luz activa | + | otros ([[#img-1|Figura 1]]). El presente trabajo propone el uso de un sistema de medición capaz de obtener la posición de la luz activa |

para poder dimensionar el interior del objeto, este sistema consta de dos módulos: un sistema de dimensionamiento 2D de visión | para poder dimensionar el interior del objeto, este sistema consta de dos módulos: un sistema de dimensionamiento 2D de visión | ||

activa, y un sistema de posicionamiento que calcula la profundidad del sistema de dimensionamiento 2D de visión activa. La | activa, y un sistema de posicionamiento que calcula la profundidad del sistema de dimensionamiento 2D de visión activa. La | ||

| Line 31: | Line 31: | ||

obtener una medición de mayor precisión y exactitud. | obtener una medición de mayor precisión y exactitud. | ||

| + | <div id='img-1'></div> | ||

{| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: 65%;" | {| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: 65%;" | ||

|- | |- | ||

| Line 42: | Line 43: | ||

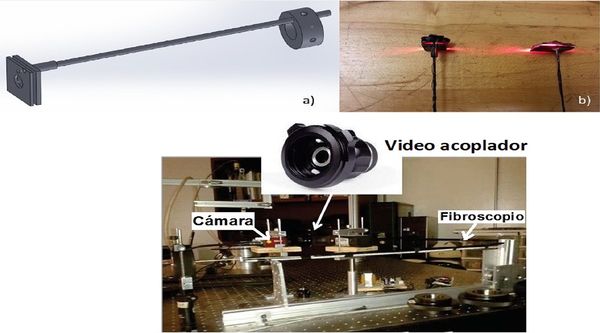

consiste en la sustitución del sistema de iluminación original del fibroscopio por un sistema que proyecta una línea de luz. Esta | consiste en la sustitución del sistema de iluminación original del fibroscopio por un sistema que proyecta una línea de luz. Esta | ||

línea de luz revela una sección transversal del interior del objeto bajo estudio. La línea de luz se obtiene mediante un LED de | línea de luz revela una sección transversal del interior del objeto bajo estudio. La línea de luz se obtiene mediante un LED de | ||

| − | potencia encerrado entre 2 placas y unido por una extensión a la punta del fibroscopio ( | + | potencia encerrado entre 2 placas y unido por una extensión a la punta del fibroscopio ([[#img-2|Figuras 2]](a) y (b)). Las imágenes de |

diferentes secciones transversales del objeto son capturadas por una cámara conectada al ocular del fibroscopio por medio de un | diferentes secciones transversales del objeto son capturadas por una cámara conectada al ocular del fibroscopio por medio de un | ||

| − | video acoplador (Figura 2 (c)). | + | video acoplador ([[#img-2|Figura 2]](c)). |

| − | + | <div id='img-2'></div> | |

{| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: 70%;" | {| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: 70%;" | ||

|- | |- | ||

| Line 123: | Line 124: | ||

posicionamiento. | posicionamiento. | ||

| − | La Tabla 1 muestra las principales características que presenta nuestro sistema para escanear el interior de piezas comparado con | + | La [[#tab-1|Tabla 1]] muestra las principales características que presenta nuestro sistema para escanear el interior de piezas comparado con |

otros sistemas. Los artículos presentados en esta tabla utilizan luz estructurada con uno o varios planos, o proyectan luz con | otros sistemas. Los artículos presentados en esta tabla utilizan luz estructurada con uno o varios planos, o proyectan luz con | ||

formas conocidas. Los trabajos que no usan luz estructurada, [23], detectan características en la imagen que son seguidas mientras | formas conocidas. Los trabajos que no usan luz estructurada, [23], detectan características en la imagen que son seguidas mientras | ||

| Line 133: | Line 134: | ||

<div class="center" style="width: auto; margin-left: auto; margin-right: auto;font-size: 75%;"> | <div class="center" style="width: auto; margin-left: auto; margin-right: auto;font-size: 75%;"> | ||

'''Tabla 1'''. Principales características de nuestro sistema de medición de interiores comparado con otras propuestas</div> | '''Tabla 1'''. Principales características de nuestro sistema de medición de interiores comparado con otras propuestas</div> | ||

| − | + | <div id='tab-1'></div> | |

<div class="center" style="width: auto; margin-left: auto; margin-right: auto;"> | <div class="center" style="width: auto; margin-left: auto; margin-right: auto;"> | ||

{| class="wikitable" style="margin: 1em auto 0.1em auto;border-collapse: collapse;font-size:85%;width:50%;" | {| class="wikitable" style="margin: 1em auto 0.1em auto;border-collapse: collapse;font-size:85%;width:50%;" | ||

| Line 317: | Line 318: | ||

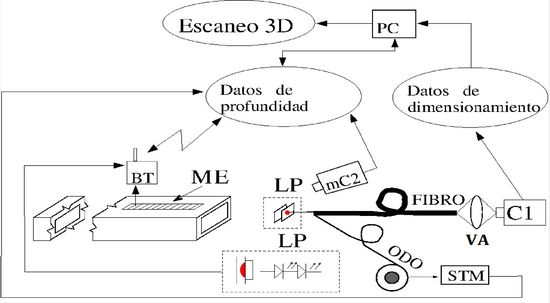

El sistema cuenta con una cámara CCD monocromática (C1) con una resolución de 2448<math>\times></math>2046 pixeles y un sensor de 1/1.45" que se | El sistema cuenta con una cámara CCD monocromática (C1) con una resolución de 2448<math>\times></math>2046 pixeles y un sensor de 1/1.45" que se | ||

| − | conecta al ocular del fibroscopio utilizando un video acoplador óptico (VA) | + | conecta al ocular del fibroscopio utilizando un video acoplador óptico (VA) ([[#img-2|Figura 2]]). Un fibroscopio de 7 mm de diámetro (FIBRO) |

con una longitud efectiva de 1320 mm, dispone de una distancia mínima de trabajo de 30.48 mm, y un campo de visión de | con una longitud efectiva de 1320 mm, dispone de una distancia mínima de trabajo de 30.48 mm, y un campo de visión de | ||

aproximadamente 50 grados alrededor del eje vertical y 40 grados alrededor del eje horizontal. La configuración del sistema del | aproximadamente 50 grados alrededor del eje vertical y 40 grados alrededor del eje horizontal. La configuración del sistema del | ||

| − | sistema de medición propuesto se muestra en la Figura 3. | + | sistema de medición propuesto se muestra en la [[#img-3|Figura 3]]. |

| − | + | <div id='img-3'></div> | |

{| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto%;max-width: 80%;" | {| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto%;max-width: 80%;" | ||

|- | |- | ||

| Line 330: | Line 331: | ||

| − | La Figura 4 muestra la cámara endoscópica (mC2), que utiliza tecnología optoelectrónica para inspeccionar áreas de difícil acceso. | + | La [[#img-4|Figura 4]] muestra la cámara endoscópica (mC2), que utiliza tecnología optoelectrónica para inspeccionar áreas de difícil acceso. |

La cámara endoscópica (mC2) tiene un diámetro de 7 mm, las dimensiones son de 510.54 mm <math>\times</math> 7.62 mm <math>\times</math> 7.62 mm, la resolución es de | La cámara endoscópica (mC2) tiene un diámetro de 7 mm, las dimensiones son de 510.54 mm <math>\times</math> 7.62 mm <math>\times</math> 7.62 mm, la resolución es de | ||

640x480 pixeles (JPEG), adquiere a 30 cuadros por segundo (FPS) y usa una luz LED ajustable en la punta de la cámara para iluminar | 640x480 pixeles (JPEG), adquiere a 30 cuadros por segundo (FPS) y usa una luz LED ajustable en la punta de la cámara para iluminar | ||

| Line 341: | Line 342: | ||

cámara 2 (mC2) localizan el plano de luz al interior del objeto. | cámara 2 (mC2) localizan el plano de luz al interior del objeto. | ||

| + | <div id='img-4'></div> | ||

{| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto%;max-width: auto;" | {| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto%;max-width: auto;" | ||

|- | |- | ||

| Line 358: | Line 360: | ||

===3.1 Visión Activa=== | ===3.1 Visión Activa=== | ||

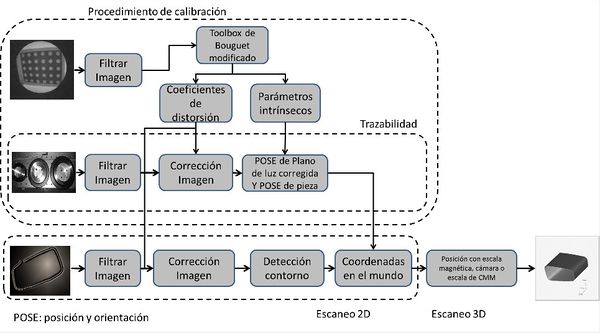

| − | El diagrama de flujo de la Figura 5 muestra la metodología para realizar el dimensionamiento o escaneo 2D. En él se muestran tres | + | El diagrama de flujo de la [[#img-5|Figura 5]] muestra la metodología para realizar el dimensionamiento o escaneo 2D. En él se muestran tres |

| − | grandes bloques de operaciones delimitados con línea punteada. Procedimiento de calibración, trazabilidad, posición y orientación | + | grandes bloques de operaciones delimitados con línea punteada. Procedimiento de calibración, trazabilidad, posición y orientación (POSE). |

| − | (POSE). | + | <div id='img-5'></div> |

| − | + | ||

{| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto%;max-width: auto;" | {| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto%;max-width: auto;" | ||

|- | |- | ||

| Line 377: | Line 378: | ||

El último bloque del diagrama describe como el contorno de las secciones transversales 2D definidas en el plano imagen, se | El último bloque del diagrama describe como el contorno de las secciones transversales 2D definidas en el plano imagen, se | ||

transforma en una nube de puntos (coordenadas 2D en el mundo) utilizando los parámetros intrínsecos de la cámara y la POSE del plano | transforma en una nube de puntos (coordenadas 2D en el mundo) utilizando los parámetros intrínsecos de la cámara y la POSE del plano | ||

| − | de luz. Cada uno de los bloques mostrados en la Figura 5 se encuentra descritos en [3]. | + | de luz. Cada uno de los bloques mostrados en la [[#img-5|Figura 5]] se encuentra descritos en [3]. |

===3.2 Determinación de la profundidad=== | ===3.2 Determinación de la profundidad=== | ||

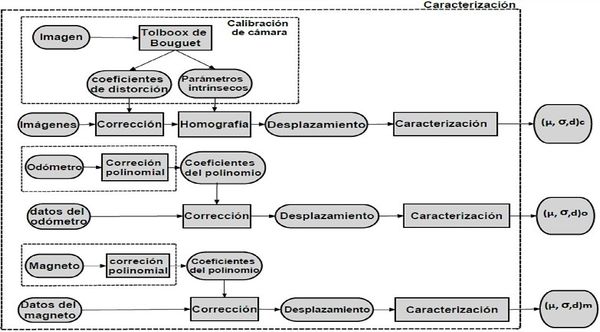

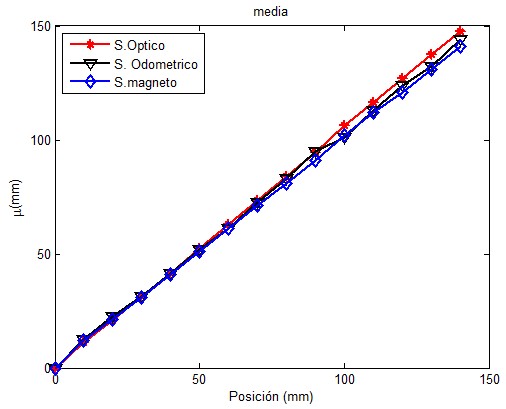

Para calcular la profundidad se usó un sistema de visión, un odómetro y un sensor magnético. Primeramente determinamos el modelo del | Para calcular la profundidad se usó un sistema de visión, un odómetro y un sensor magnético. Primeramente determinamos el modelo del | ||

| − | sensor, después hicimos una corrección, la caracterización del sensor (Figura 6) y finalmente la fusión de los datos obtenidos | + | sensor, después hicimos una corrección, la caracterización del sensor ([[#img-6|Figura 6]]) y finalmente la fusión de los datos obtenidos |

por los sensores. | por los sensores. | ||

| − | + | <div id='img-6'></div> | |

{| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto%;max-width: auto;" | {| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto%;max-width: auto;" | ||

|- | |- | ||

| Line 405: | Line 406: | ||

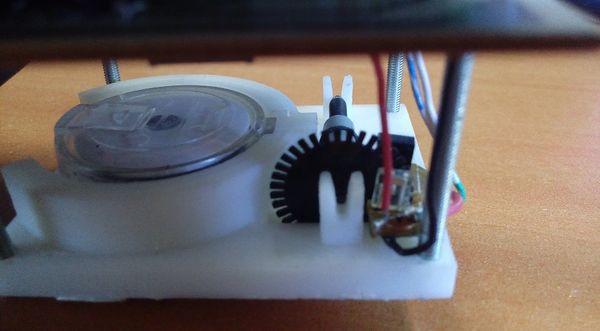

El odómetro es un sistema que está compuesto por un conjunto de tarjetas electrónicas STM 32F4 discovery que se encargan de adquirir | El odómetro es un sistema que está compuesto por un conjunto de tarjetas electrónicas STM 32F4 discovery que se encargan de adquirir | ||

| − | y procesar la señal de los pulsos generados (Figura 7). Entre las partes que componen el sistema se encuentra un módulo de | + | y procesar la señal de los pulsos generados ([[#img-7|Figura 7]]). Entre las partes que componen el sistema se encuentra un módulo de |

medición lineal. El módulo lineal usa un encoder opto-electrónico con un carrete acoplado al mismo, se jala un cable por un sistema | medición lineal. El módulo lineal usa un encoder opto-electrónico con un carrete acoplado al mismo, se jala un cable por un sistema | ||

dentado con una cadena en la que cada vuelta el encoder hace un conteo de los pulsos generados. El conteo de los pulsos generados | dentado con una cadena en la que cada vuelta el encoder hace un conteo de los pulsos generados. El conteo de los pulsos generados | ||

| Line 412: | Line 413: | ||

Coordenadas (CMM) y la metodología presentada en [52] para una sola dimensión. La caracterización del sensor se hizo de forma | Coordenadas (CMM) y la metodología presentada en [52] para una sola dimensión. La caracterización del sensor se hizo de forma | ||

estadística aproximando la medición de los sensores a una distribución paramétrica normal. | estadística aproximando la medición de los sensores a una distribución paramétrica normal. | ||

| − | + | <div id='img-7'></div> | |

{| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto;max-width: auto;" | {| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto;max-width: auto;" | ||

|- | |- | ||

| Line 427: | Line 428: | ||

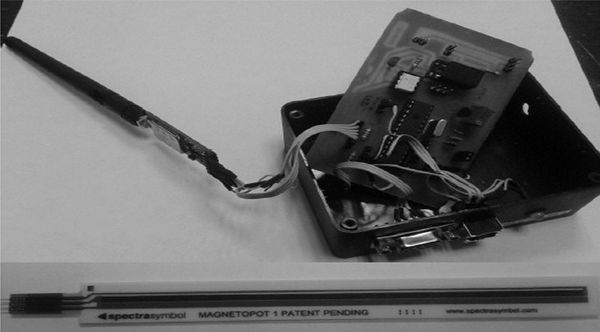

| − | El sensor magnético ( | + | El sensor magnético ([[#img-8|Figura 8]]) está formado por un imán de posición sobre un eje de movimiento del dispositivo. El sistema de |

medición propone el uso de una escala magnética que funciona como un potenciómetro con una resistencia de 10K cuyo desplazamiento | medición propone el uso de una escala magnética que funciona como un potenciómetro con una resistencia de 10K cuyo desplazamiento | ||

depende de las posiciones del imán, para calcular el desplazamiento lineal al hacer presión sobre la capa superior del sensor, un | depende de las posiciones del imán, para calcular el desplazamiento lineal al hacer presión sobre la capa superior del sensor, un | ||

| Line 434: | Line 435: | ||

Medición de Coordenadas (CMM) como en [52]. La caracterización del sensor de desplazamiento magnético se hizo de forma estadística | Medición de Coordenadas (CMM) como en [52]. La caracterización del sensor de desplazamiento magnético se hizo de forma estadística | ||

considerando una distribución normal. | considerando una distribución normal. | ||

| − | + | <div id='img-8'></div> | |

{| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto%;max-width: auto;" | {| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto%;max-width: auto;" | ||

|- | |- | ||

| Line 520: | Line 521: | ||

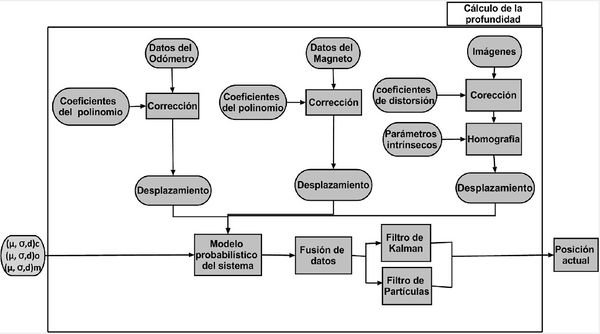

La alineación de los sensores es importante ya que la posición inicial del sistema se estima con esta referencia. Los datos | La alineación de los sensores es importante ya que la posición inicial del sistema se estima con esta referencia. Los datos | ||

| − | obtenidos de los sensores son fusionados para mejorar la estimación de la posición del generador de luz activa (Figura 9). El | + | obtenidos de los sensores son fusionados para mejorar la estimación de la posición del generador de luz activa ([[#img-9|Figura 9]]). El |

odómetro y magneto adquieren datos los cuales son corregidos usando una curva polinómica previamente calculada. Las imágenes de la | odómetro y magneto adquieren datos los cuales son corregidos usando una curva polinómica previamente calculada. Las imágenes de la | ||

cámara son corregidas en cuanto la distorsión radial usando los coeficientes de distorsión. | cámara son corregidas en cuanto la distorsión radial usando los coeficientes de distorsión. | ||

| + | <div id='img-9'></div> | ||

{| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto%;max-width: auto;" | {| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto%;max-width: auto;" | ||

|- | |- | ||

| Line 595: | Line 597: | ||

===3.3.1 Filtro de Kalman === | ===3.3.1 Filtro de Kalman === | ||

| + | |||

El Filtro de Kalman(FK) se utiliza para modelar sistemas lineales en el que las mediciones del sistema se ven afectadas por ruido | El Filtro de Kalman(FK) se utiliza para modelar sistemas lineales en el que las mediciones del sistema se ven afectadas por ruido | ||

aleatorio provenientes del comportamiento del sistema. Para hacer una estimación de los valores de la posición, el filtro requiere | aleatorio provenientes del comportamiento del sistema. Para hacer una estimación de los valores de la posición, el filtro requiere | ||

| Line 685: | Line 688: | ||

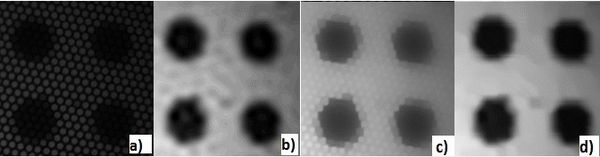

El fibroscopio genera estructuras en forma de panal de abeja que se manifiestan en las imágenes capturadas. Estas estructuras deben | El fibroscopio genera estructuras en forma de panal de abeja que se manifiestan en las imágenes capturadas. Estas estructuras deben | ||

ser filtradas de lo contrario el procedimiento de calibración no puede realizarse a menos que se desarrolle un extractor de | ser filtradas de lo contrario el procedimiento de calibración no puede realizarse a menos que se desarrolle un extractor de | ||

| − | características inmune a este tipo de ruido. La Figura 10 muestra la imagen de un patrón de calibración capturado a través del | + | características inmune a este tipo de ruido. La [[#img-10|Figura 10]] muestra la imagen de un patrón de calibración capturado a través del |

fibroscopio. En este trabajo se utilizaron dos filtros, uno propuesto por [56] y el otro propuesto por [57]. Después de algunas | fibroscopio. En este trabajo se utilizaron dos filtros, uno propuesto por [56] y el otro propuesto por [57]. Después de algunas | ||

pruebas, se estableció que la aplicación de ambos filtros en secuencia, primero Winter y luego Xu, da excelentes resultados. La | pruebas, se estableció que la aplicación de ambos filtros en secuencia, primero Winter y luego Xu, da excelentes resultados. La | ||

| − | secuencia opuesta no funciona pues los resultados son similares con solo aplicar el filtro de Winter, Figura 10 (b). La Figura 10 | + | secuencia opuesta no funciona pues los resultados son similares con solo aplicar el filtro de Winter, [[#img-10|Figura 10]] (b). La [[#img-10|Figura 10]] |

muestra los resultados individuales de ambos filtros y los resultados cuando se aplican en secuencia. | muestra los resultados individuales de ambos filtros y los resultados cuando se aplican en secuencia. | ||

| + | <div id='img-10'></div> | ||

{| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: 80%;" | {| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: 80%;" | ||

|- | |- | ||

| Line 703: | Line 707: | ||

utilizar como patrón de referencia. | utilizar como patrón de referencia. | ||

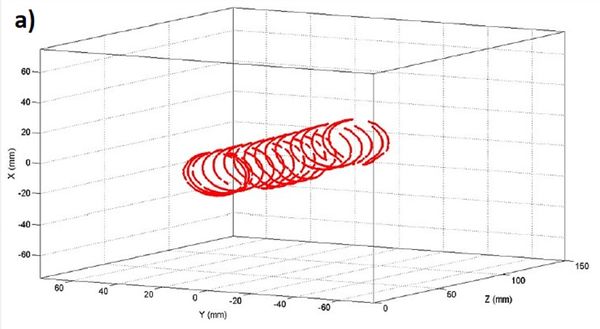

| − | La Figura 11 representa un escaneo 3D de interior del cilindro de frenado de autos. La Figura 11 (a) muestra el escaneo de varias | + | La [[#img-11|Figura 11]] representa un escaneo 3D de interior del cilindro de frenado de autos. La [[#img-11|Figura 11]](a) muestra el escaneo de varias |

| − | secciones transversales en el interior del cilindro maestro. La Figura 11 (b) muestra el error del diámetro al comparar el diámetro | + | secciones transversales en el interior del cilindro maestro. La [[#img-11|Figura 11]](b) muestra el error del diámetro al comparar el diámetro |

del cilindro ajustado con todas las secciones transversales medidas por el sistema propuesto y el diámetro medido por una CMM. El | del cilindro ajustado con todas las secciones transversales medidas por el sistema propuesto y el diámetro medido por una CMM. El | ||

| − | error es de 0.028 mm con una incertidumbre de 0.050 mm la cual cubre dicho error. En la Figura 11 (b) también se aprecia la | + | error es de 0.028 mm con una incertidumbre de 0.050 mm la cual cubre dicho error. En la [[#img-11|Figura 11]](b) también se aprecia la |

cilindricidad de 0.186 mm. El error de diámetro es una prueba de la exactitud del sistema propuesto en el dimensionamiento 2D. Los | cilindricidad de 0.186 mm. El error de diámetro es una prueba de la exactitud del sistema propuesto en el dimensionamiento 2D. Los | ||

| − | resultados de la Figura 11 (b) se obtuvieron con el software de medición certificado GOM Inspect V8. | + | resultados de la [[#img-11|Figura 11]](b) se obtuvieron con el software de medición certificado GOM Inspect V8. |

| − | + | <div id='img-11'></div> | |

{| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto;max-width: auto;" | {| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto;max-width: auto;" | ||

|- | |- | ||

|style="padding:10px;"| [[File:Draft_Gonzalez-Barbosa_236306777_2789_cilindro1.jpg|600px]] | |style="padding:10px;"| [[File:Draft_Gonzalez-Barbosa_236306777_2789_cilindro1.jpg|600px]] | ||

|- | |- | ||

| − | | style="text-align: center;font-size: 75%;"|(a) Escaneo 3D del interior de un cilindro de frenado de autos como el mostrado en la Figura | + | | style="text-align: center;font-size: 75%;"|(a) Escaneo 3D del interior de un cilindro de frenado de autos como el mostrado en la [[#img-1|Figura 1]](b) |

|- | |- | ||

|style="padding:10px;"| [[File:Draft_Gonzalez-Barbosa_236306777_9073_cilindro2.jpg|600px]] | |style="padding:10px;"| [[File:Draft_Gonzalez-Barbosa_236306777_9073_cilindro2.jpg|600px]] | ||

| Line 744: | Line 748: | ||

probabilidad para las lecturas de los sensores. | probabilidad para las lecturas de los sensores. | ||

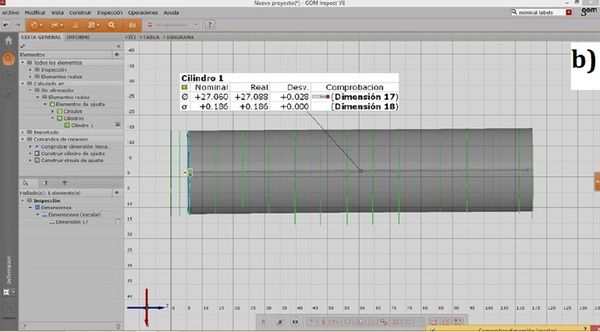

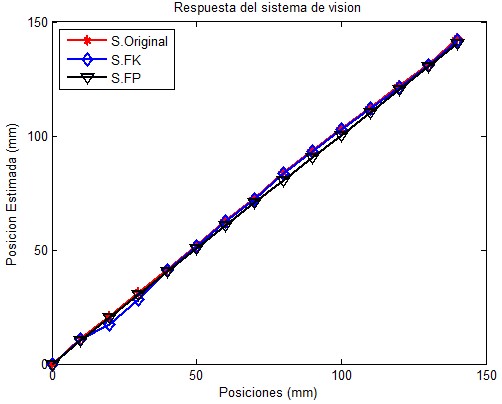

| − | La Figura 12 muestra los resultados de las posiciones de la luz activa provenientes de datos de diferentes sensores, 15 posiciones | + | La [[#img-12|Figura 12]] muestra los resultados de las posiciones de la luz activa provenientes de datos de diferentes sensores, 15 posiciones |

diferentes se miden. La descripción del modelo del sistema está relacionado con estas mediciones, con los resultados obtenidos se | diferentes se miden. La descripción del modelo del sistema está relacionado con estas mediciones, con los resultados obtenidos se | ||

observa el comportamiento de un sistema dinámico lineal de tres variables independientes con la misma tendencia. A partir de conocer | observa el comportamiento de un sistema dinámico lineal de tres variables independientes con la misma tendencia. A partir de conocer | ||

| Line 750: | Line 754: | ||

odométrico, se demuestra que a partir de este intervalo se tienen un valor de 0.1 mm de error acumulado con referencia al valor | odométrico, se demuestra que a partir de este intervalo se tienen un valor de 0.1 mm de error acumulado con referencia al valor | ||

medido para cada posición. | medido para cada posición. | ||

| − | + | <div id='img-12'></div> | |

{| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto;max-width: auto;" | {| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto;max-width: auto;" | ||

|- | |- | ||

| Line 760: | Line 764: | ||

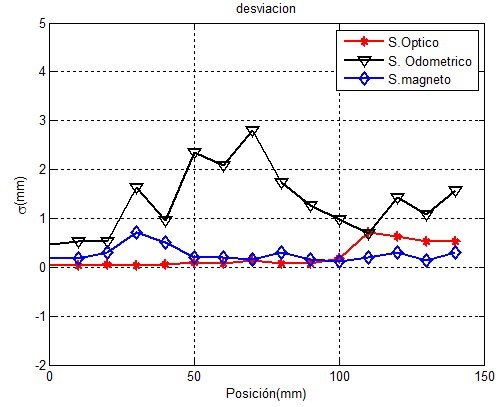

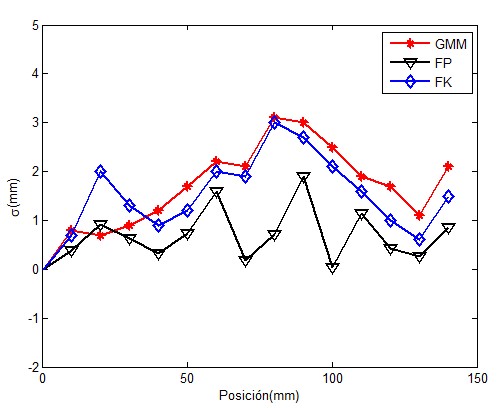

Cuando se hacen varias mediciones se puede obtener un valor estadístico del error, el error asociado a las mediciones de la posición | Cuando se hacen varias mediciones se puede obtener un valor estadístico del error, el error asociado a las mediciones de la posición | ||

| − | se presenta en la Figura 13, con estos valores sabemos que la medición de la posición es proporcional a la desviación que presenta, | + | se presenta en la [[#img-13|Figura 13]], con estos valores sabemos que la medición de la posición es proporcional a la desviación que presenta, |

y nos da la exactitud de éstas medidas, es decir, a mayor repetibilidad mayor exactitud. Al tomar en cuenta estas medidas nos dirá | y nos da la exactitud de éstas medidas, es decir, a mayor repetibilidad mayor exactitud. Al tomar en cuenta estas medidas nos dirá | ||

| − | que tan preciso es el sensor con el que estamos midiendo. En la Figura 13 podemos apreciar que las incertidumbre en los datos | + | que tan preciso es el sensor con el que estamos midiendo. En la [[#img-13|Figura 13]] podemos apreciar que las incertidumbre en los datos |

presentados están contenidas en el rango de 0 hasta 3 mm . El intervalo en el que el sensor odométrico mostró un mayor error | presentados están contenidas en el rango de 0 hasta 3 mm . El intervalo en el que el sensor odométrico mostró un mayor error | ||

sistemático es de 50 mm a 100 mm que presenta incertidumbres cercanas a 3 mm, mientras que el sensor magnético en el intervalo de 20 | sistemático es de 50 mm a 100 mm que presenta incertidumbres cercanas a 3 mm, mientras que el sensor magnético en el intervalo de 20 | ||

| Line 769: | Line 773: | ||

mayor capacidad de adquirir los datos, esta información nos es útil analizarla ya que posteriormente al hacer la fusión de los datos | mayor capacidad de adquirir los datos, esta información nos es útil analizarla ya que posteriormente al hacer la fusión de los datos | ||

esperamos que los sensores con menor variabilidad incluyan en la estimación final de la posición. | esperamos que los sensores con menor variabilidad incluyan en la estimación final de la posición. | ||

| − | + | <div id='img-13'></div> | |

{| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto;max-width: auto;" | {| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto;max-width: auto;" | ||

|- | |- | ||

| Line 786: | Line 790: | ||

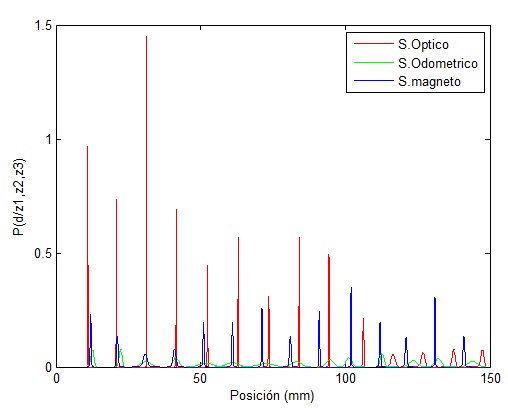

variación se ajusta a una distribución normal que representamos con PDF's centrado en la media que es el mejor valor de la posición | variación se ajusta a una distribución normal que representamos con PDF's centrado en la media que es el mejor valor de la posición | ||

medido en un intervalo de medición de 10 mm y con una dispersión en proporción del error de esta medición, conocer la distribución | medido en un intervalo de medición de 10 mm y con una dispersión en proporción del error de esta medición, conocer la distribución | ||

| − | del conjunto de datos para cada sensor nos proporciona información de la posición. En la Figura 14 se muestran tres PDF's, la | + | del conjunto de datos para cada sensor nos proporciona información de la posición. En la [[#img-14|Figura 14]] se muestran tres PDF's, la |

PDF1(x) representa al sensor óptico en rojo, en verde la PDF2(x) corresponde al sensor odométrico y en azul PDF3(x) al sensor magnético. Nuestro trabajo está enfocado en fusionar los resultados de estas distribuciones para dar una mejor estimación de la posición. | PDF1(x) representa al sensor óptico en rojo, en verde la PDF2(x) corresponde al sensor odométrico y en azul PDF3(x) al sensor magnético. Nuestro trabajo está enfocado en fusionar los resultados de estas distribuciones para dar una mejor estimación de la posición. | ||

| − | + | <div id='img-14'></div> | |

{| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto;max-width: auto;" | {| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto;max-width: auto;" | ||

|- | |- | ||

| Line 798: | Line 802: | ||

===4.3 Interpolación de PDF's=== | ===4.3 Interpolación de PDF's=== | ||

| − | En la Figura 14 se muestra el conjunto de datos medidos en posiciones discretas definidas con distribuciones de probabilidad (PDF's), sin embargo, en la práctica cuando se realizan las mediciones hay datos en los que el sistema se encuentra en alguna posición en la que no se guarda ese valor de medición, ya que la presencia de información faltante lleva consigo perdida de precisión en las estimaciones se debe tomar en cuenta alguna metodología para estimar estos datos faltantes. Para encontrar una solución a esto, proponemos el uso del método de la interpolación lineal con ella llegamos a la obtención del modelado de la distribución de la posición cuando toma un valor fuera de un intervalo discreto donde no hay mediciones disponibles. | + | En la [[#img-14|Figura 14]] se muestra el conjunto de datos medidos en posiciones discretas definidas con distribuciones de probabilidad (PDF's), sin embargo, en la práctica cuando se realizan las mediciones hay datos en los que el sistema se encuentra en alguna posición en la que no se guarda ese valor de medición, ya que la presencia de información faltante lleva consigo perdida de precisión en las estimaciones se debe tomar en cuenta alguna metodología para estimar estos datos faltantes. Para encontrar una solución a esto, proponemos el uso del método de la interpolación lineal con ella llegamos a la obtención del modelado de la distribución de la posición cuando toma un valor fuera de un intervalo discreto donde no hay mediciones disponibles. |

La interpolación consiste en hallar un dato dentro de un intervalo en el que conocemos los valores extremos. Los puntos <math>X_1(N,\mu ,\sigma )</math> y | La interpolación consiste en hallar un dato dentro de un intervalo en el que conocemos los valores extremos. Los puntos <math>X_1(N,\mu ,\sigma )</math> y | ||

| Line 809: | Line 813: | ||

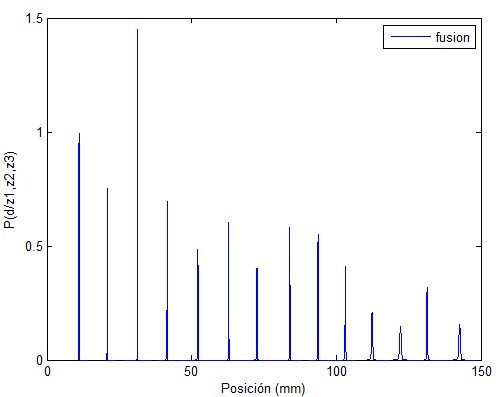

sobre el resultado de la medición cada distribución aporta información complementaria que puede incrementar la exactitud de la | sobre el resultado de la medición cada distribución aporta información complementaria que puede incrementar la exactitud de la | ||

estimación de la posición del LED. Los resultados de las distribuciones que se fusionan mediante el producto de las PDF individuales | estimación de la posición del LED. Los resultados de las distribuciones que se fusionan mediante el producto de las PDF individuales | ||

| − | de cada uno de los valores proporcionados por los diferentes sensores se muestran en la Figura 15. El producto final muestra una | + | de cada uno de los valores proporcionados por los diferentes sensores se muestran en la [[#img-15|Figura 15]]. El producto final muestra una |

incertidumbre menor que cuando el error es proveniente de cada uno de los sensores de manera individual, ya que es posible que el | incertidumbre menor que cuando el error es proveniente de cada uno de los sensores de manera individual, ya que es posible que el | ||

sensor que presente una menor incertidumbre tendrá mayor impacto sobre el resultado de la medición, esta distribución total está | sensor que presente una menor incertidumbre tendrá mayor impacto sobre el resultado de la medición, esta distribución total está | ||

asociada a un nuevo valor de posición. | asociada a un nuevo valor de posición. | ||

| − | + | <div id='img-15'></div> | |

{| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto;max-width: auto;" | {| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto;max-width: auto;" | ||

|- | |- | ||

| Line 825: | Line 829: | ||

Una vez obtenida la distribución total se calcula la media y la desviación estándar estimados asociados a esta distribución, el | Una vez obtenida la distribución total se calcula la media y la desviación estándar estimados asociados a esta distribución, el | ||

estrechamiento de la distribución indica que la incertidumbre implícita se reduce, y la media se centra con mayor precisión con | estrechamiento de la distribución indica que la incertidumbre implícita se reduce, y la media se centra con mayor precisión con | ||

| − | respecto a la posición objetivo real. En la Tabla 2 se recopilan los resultados. Con este método modelamos el error de la posición | + | respecto a la posición objetivo real. En la [[#tab-2|Tabla 2]] se recopilan los resultados. Con este método modelamos el error de la posición |

para la localización del LED de potencia, hemos demostrado que este método es capaz de encontrar una estimación de la posición del | para la localización del LED de potencia, hemos demostrado que este método es capaz de encontrar una estimación de la posición del | ||

LED y podemos concluir que este método es capaz de realizar una estimación de la posición aun cuando los valores de los sensores | LED y podemos concluir que este método es capaz de realizar una estimación de la posición aun cuando los valores de los sensores | ||

| Line 846: | Line 850: | ||

tiempo. | tiempo. | ||

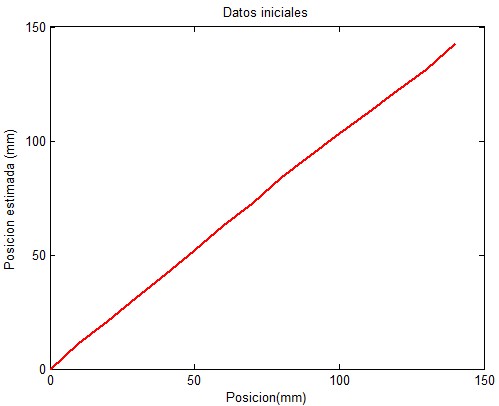

| − | La Figura 16 representa los valores de medición de los datos iniciales que son procesados por ambos filtros. Los filtros procesan la | + | La [[#img-16|Figura 16]] representa los valores de medición de los datos iniciales que son procesados por ambos filtros. Los filtros procesan la |

medición de 15 muestras dando como resultado la señal estimada X. | medición de 15 muestras dando como resultado la señal estimada X. | ||

| − | La Figura 17 muestra la estimación de las posiciones después de que los datos son procesados por los filtros, junto con los valores | + | La [[#img-17|Figura 17]] muestra la estimación de las posiciones después de que los datos son procesados por los filtros, junto con los valores |

del movimiento real del objeto (rojo) con sus respectivos valores de posición estimados con ambos filtros, el filtro de kalman | del movimiento real del objeto (rojo) con sus respectivos valores de posición estimados con ambos filtros, el filtro de kalman | ||

(azul) y el filtro de partículas(negro). Los resultados muestran la estimación de la posición en cada punto de medición, se observa | (azul) y el filtro de partículas(negro). Los resultados muestran la estimación de la posición en cada punto de medición, se observa | ||

que los valores de posición son estimados son muy similares a la real. | que los valores de posición son estimados son muy similares a la real. | ||

| − | + | <div id='img-16'></div> | |

{| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto;max-width: auto;" | {| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto;max-width: auto;" | ||

|- | |- | ||

| Line 860: | Line 864: | ||

|} | |} | ||

| − | + | <div id='img-17'></div> | |

{| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto;max-width: auto;" | {| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto;max-width: auto;" | ||

|- | |- | ||

| Line 869: | Line 873: | ||

| − | En la Figura 18, se muestra la incertidumbre de la posición con los métodos implementados, la línea roja representa la incertidumbre | + | En la [[#img-18|Figura 18]], se muestra la incertidumbre de la posición con los métodos implementados, la línea roja representa la incertidumbre |

generada al fusionar las incertidumbres procedentes de los sensores utilizados observamos que existe una diferencia considerable con | generada al fusionar las incertidumbres procedentes de los sensores utilizados observamos que existe una diferencia considerable con | ||

respecto a la incertidumbre obtenida de manera individual de cada sensor, los resultados con este método oscilan entre 1 mm a 3 mm, | respecto a la incertidumbre obtenida de manera individual de cada sensor, los resultados con este método oscilan entre 1 mm a 3 mm, | ||

| Line 876: | Line 880: | ||

respectivamente, los valores obtenidos nos indican qué tan fiable es la medición que estamos obteniendo con nuestro sistema de | respectivamente, los valores obtenidos nos indican qué tan fiable es la medición que estamos obteniendo con nuestro sistema de | ||

posicionamiento, al tomar una decisión del método a utilizar para mejorar la posición del sistema. | posicionamiento, al tomar una decisión del método a utilizar para mejorar la posición del sistema. | ||

| − | + | <div id='img-18'></div> | |

{| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto;max-width: auto;" | {| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto;max-width: auto;" | ||

|- | |- | ||

| Line 885: | Line 889: | ||

| − | Los resultados de los algoritmos propuestos se muestran en la Tabla 2, donde se observan las posiciones y el error de medición, | + | Los resultados de los algoritmos propuestos se muestran en la [[#tab-2|Tabla 2]], donde se observan las posiciones y el error de medición, |

tanto para el algoritmo de mezcla de gaussianas con EM, FK y FP, los resultados muestran que los métodos implementados tienden a | tanto para el algoritmo de mezcla de gaussianas con EM, FK y FP, los resultados muestran que los métodos implementados tienden a | ||

aproximarse a la posición real del sistema y ambos filtros pueden ser utilizados para la estimación de la posición, sin embargo, el | aproximarse a la posición real del sistema y ambos filtros pueden ser utilizados para la estimación de la posición, sin embargo, el | ||

filtro de partículas es el algoritmo que realiza una mejor estimación de la posición en comparación con los otros métodos, además, | filtro de partículas es el algoritmo que realiza una mejor estimación de la posición en comparación con los otros métodos, además, | ||

| − | también se puede ver en los resultados de la Tabla 2 como la desviación estándar es menor en el algoritmo filtro de partículas lo | + | también se puede ver en los resultados de la [[#tab-2|Tabla 2]] como la desviación estándar es menor en el algoritmo filtro de partículas lo |

que indica que los resultados son más estables manteniéndose el LED localizado a lo largo de todo el recorrido del escaneo. Se puede | que indica que los resultados son más estables manteniéndose el LED localizado a lo largo de todo el recorrido del escaneo. Se puede | ||

observar como todos los valores de posiciones y el error comprendido entre los valores obtenidos se reducen drásticamente con la | observar como todos los valores de posiciones y el error comprendido entre los valores obtenidos se reducen drásticamente con la | ||

| Line 895: | Line 899: | ||

otros métodos. | otros métodos. | ||

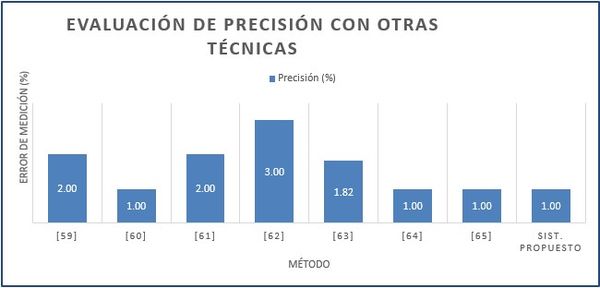

| − | Para llevar a cabo la evaluación del proceso de medición de nuestro sensor, se calcularon los valores de incertidumbre de la posición en cada punto de medición, siguiendo los cálculos establecidos en [58], mostrados en la Tabla 2 y en la Figura 19. Finalmente, la | + | Para llevar a cabo la evaluación del proceso de medición de nuestro sensor, se calcularon los valores de incertidumbre de la posición en cada punto de medición, siguiendo los cálculos establecidos en [58], mostrados en la [[#tab-2|Tabla 2]] y en la [[#img-19|Figura 19]]. Finalmente, la [[#tab-3|Tabla 3]] muestra el error promedio de los valores de incertidumbre de las mediciones obtenidas en la [[#tab-2|Tabla 2]], analizando los resultados obtenidos se puede ver que estos valores representan el 1% del error en la medición calculado a partir de la dispersión de los datos con respecto al valor promedio de las medidas obtenidas por el sensor. |

<div class="center" style="width: auto; margin-left: auto; margin-right: auto;font-size: 75%;"> | <div class="center" style="width: auto; margin-left: auto; margin-right: auto;font-size: 75%;"> | ||

'''Tabla 2'''. Datos obtenidos de todas las estimaciones (mm)</div><br /> | '''Tabla 2'''. Datos obtenidos de todas las estimaciones (mm)</div><br /> | ||

<center> | <center> | ||

| + | <div id='tab-2'></div> | ||

{| class="wikitable" align="center" style="margin:0;text-align: center;font-size:85%;" | {| class="wikitable" align="center" style="margin:0;text-align: center;font-size:85%;" | ||

|-style="border-top:2px solid; border-bottom:2px solid;" | |-style="border-top:2px solid; border-bottom:2px solid;" | ||

| Line 940: | Line 945: | ||

'''Tabla 3'''. Incertidumbres obtenidas de estimaciónes de posición discretas (mm) | '''Tabla 3'''. Incertidumbres obtenidas de estimaciónes de posición discretas (mm) | ||

</div> | </div> | ||

| − | + | <div id='tab-3'></div> | |

<center> | <center> | ||

{| class="wikitable" align="center" style="margin:0;text-align: center;font-size:85%;" | {| class="wikitable" align="center" style="margin:0;text-align: center;font-size:85%;" | ||

| Line 952: | Line 957: | ||

Los resultados experimentales muestran que el error de medición del sensor propuesto está dentro del 1%. Este resultado se compara a continuación con el obtenido en otros trabajos, en los que se presentan sistemas que proporcionan información útil para aplicaciones de navegación e inspección de tuberías y modelado 3D. Autores como [59] presentan un sistema de visión capaz de obtener información de la profundidad con un error de estimación menor al 2%. Un sistema de visión para el escaneo de tuberías 3D como el propuesto en [60], en el método de escaneo consiste en proyectar un haz de luz circular sobre la superficie del tubo, que permite calcular la posición de escaneo con una resolución de menos del 1%. En [61] demuestran cómo se puede realizar la medición del perfil interno de piezas cilíndricas con una resolución del 2%. Mientras que en [62] proponen un sistema de medición para la reconstrucción 3D de tuberías, el método consiste en estimar el movimiento de la cámara con referencia las coordenadas 3D de la sección de luz, este sistema puede estimar el movimiento de la cámara con un error del 3%. En [63] proponen un método de localización simultánea para estimar con precisión la posición de un instrumento utilizado con aplicaciones quirúrgicas, con una precisión menor del 2%. En [64] proponen un sistema para la inspección de tuberías que consiste en un robot móvil que se desplaza en el interior del ducto, la posición del móvil es medida a través de un distanciómetro láser con una precisión del 3%. En [65] presentan una técnica de estimación de la posición de la cámara dentro de la tubería con una precisión del 1%. De los resultados obtenidos con el sistema de medición propuesto en nuestro trabajo, se deduce que la precisión de nuestro sensor puede considerarse del mismo nivel que los trabajados mencionados, lo que demuestra que este sensor es adecuado para utilizarse en procesos donde es posible adaptar mediciones ópticas donde se espera que el sistema sea capaz de evaluar el perfil de la superficie interna de la pieza a medir. | Los resultados experimentales muestran que el error de medición del sensor propuesto está dentro del 1%. Este resultado se compara a continuación con el obtenido en otros trabajos, en los que se presentan sistemas que proporcionan información útil para aplicaciones de navegación e inspección de tuberías y modelado 3D. Autores como [59] presentan un sistema de visión capaz de obtener información de la profundidad con un error de estimación menor al 2%. Un sistema de visión para el escaneo de tuberías 3D como el propuesto en [60], en el método de escaneo consiste en proyectar un haz de luz circular sobre la superficie del tubo, que permite calcular la posición de escaneo con una resolución de menos del 1%. En [61] demuestran cómo se puede realizar la medición del perfil interno de piezas cilíndricas con una resolución del 2%. Mientras que en [62] proponen un sistema de medición para la reconstrucción 3D de tuberías, el método consiste en estimar el movimiento de la cámara con referencia las coordenadas 3D de la sección de luz, este sistema puede estimar el movimiento de la cámara con un error del 3%. En [63] proponen un método de localización simultánea para estimar con precisión la posición de un instrumento utilizado con aplicaciones quirúrgicas, con una precisión menor del 2%. En [64] proponen un sistema para la inspección de tuberías que consiste en un robot móvil que se desplaza en el interior del ducto, la posición del móvil es medida a través de un distanciómetro láser con una precisión del 3%. En [65] presentan una técnica de estimación de la posición de la cámara dentro de la tubería con una precisión del 1%. De los resultados obtenidos con el sistema de medición propuesto en nuestro trabajo, se deduce que la precisión de nuestro sensor puede considerarse del mismo nivel que los trabajados mencionados, lo que demuestra que este sensor es adecuado para utilizarse en procesos donde es posible adaptar mediciones ópticas donde se espera que el sistema sea capaz de evaluar el perfil de la superficie interna de la pieza a medir. | ||

| − | + | <div id='img-19'></div> | |

{| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto;max-width: auto;" | {| style="text-align: center; border: 1px solid #BBB; margin: 1em auto; width: auto;max-width: auto;" | ||

|- | |- | ||

| Line 971: | Line 976: | ||

comportamientos similares, se encontró que existe un error sistemático de 1.64 mm y 0.73 mm respectivamente logrando de esta forma | comportamientos similares, se encontró que existe un error sistemático de 1.64 mm y 0.73 mm respectivamente logrando de esta forma | ||

obtener resultados que permiten mejorar la medición de la posición del LED. Los resultados del posicionamiento obtenidos con el | obtener resultados que permiten mejorar la medición de la posición del LED. Los resultados del posicionamiento obtenidos con el | ||

| − | sistema de medición propuesto se comparan con los resultados de trabajos existentes y se presentan en la Figura 19, la solución que | + | sistema de medición propuesto se comparan con los resultados de trabajos existentes y se presentan en la [[#img-19|Figura 19]], la solución que |

proporcionan estas técnicas son cercanos a los presentados por nuestro sistema, lo que indica que el sistema de escaneo se puede | proporcionan estas técnicas son cercanos a los presentados por nuestro sistema, lo que indica que el sistema de escaneo se puede | ||

utilizar para diferentes aplicaciones | utilizar para diferentes aplicaciones | ||

Latest revision as of 15:15, 16 July 2021

Resumen

En este trabajo presentamos un sistema de posicionamiento de visión activa para el escaneo 3D del interior de piezas. El diseño del sistema propuesto consta de dos módulos: un sistema de dimensionamiento 2D de visión activa, y un sistema que posiciona el módulo de visión activa. El sistema de posicionamiento es capaz de determinar la profundidad del sistema de dimensionamiento 2D de visión activa en el interior del objeto a escanear usando varios sensores. Las principales contribuciones de este trabajo son la caracterización del sistema de dimensionamiento 2D, y el desarrollo de algoritmos de posicionamiento de la luz activa con énfasis en el modelado y fusión de sensores. El sistema puede utilizarse como un sistema de dimensionamiento en aplicaciones industriales como la industria metal mecánica, la aeronáutica, la medicina, en el control de calidad y en áreas de visión por computadora.

Palabras clave: Estimación de la posición, procesamiento de imágenes, fusión de datos, modelado sensorial

Abstract

In this work we present an active positioning system for 3D scan of interior parts. The design of the proposed system consists of two modules: an active 2D dimensional system and positional system based on active vision. The active 2D dimensional system is able to determine the depth of the 2D dimensional system inside the object to be scanned using several sensors. The main contributions of this work are the characterization of the 2D dimensional system and the development of active light positioning algorithms with emphasis on the modeling and fusion of the sensors. The system can be used as a dimensional system in industrial applications such as the metal mechanical industry, aeronautics industry, medicine, quality control and computer vision.

Keywords: Pose estimation, image processing, data fusion, sensor models

1. Introducción

En este trabajo presentamos una propuesta de un sistema de posicionamiento de luz activa para el escaneo 3D del interior de piezas industriales con gran utilidad en diferentes tipos de industria como la metal mecánica, la aeronáutica, la militar y la medicina que requieren constantemente la medición de dimensiones internas de la pieza bajo inspección. Como ejemplos de aplicación podemos mencionar la medición del interior del cilindro maestro que forma parte del sistema de frenado de los autos, el escaneo 3D del interior del cuerpo humano, la medición en el interior de tuberías, la medición del interior de botellas hechas de plástico, entre otros (Figura 1). El presente trabajo propone el uso de un sistema de medición capaz de obtener la posición de la luz activa para poder dimensionar el interior del objeto, este sistema consta de dos módulos: un sistema de dimensionamiento 2D de visión activa, y un sistema de posicionamiento que calcula la profundidad del sistema de dimensionamiento 2D de visión activa. La profundidad es calculada por la información proveniente de varios sensores de forma independiente los cuales son fusionados para obtener una medición de mayor precisión y exactitud.

El sistema de dimensionamiento del interior de piezas con difícil acceso está basado en un fibroscopio modificado. La modificación

consiste en la sustitución del sistema de iluminación original del fibroscopio por un sistema que proyecta una línea de luz. Esta

línea de luz revela una sección transversal del interior del objeto bajo estudio. La línea de luz se obtiene mediante un LED de

potencia encerrado entre 2 placas y unido por una extensión a la punta del fibroscopio (Figuras 2(a) y (b)). Las imágenes de

diferentes secciones transversales del objeto son capturadas por una cámara conectada al ocular del fibroscopio por medio de un

video acoplador (Figura 2(c)).

El sistema que determina la profundidad de la visión activa, está conformado por un sistema de visión, un sensor magnético y un

odómetro. El sistema de visión consta de una cámara y de un patrón de referencia pegado en las placas del sistema de iluminación,

unidos al sistema de guiado del fibroscopio que componen al sistema de visión activa. El patrón está constituido por una matriz de 8

columnas de círculos y 8 renglones de círculos de color blanco con fondo negro. La cámara es del tipo endoscopio digital flexible de

7 mm de diámetro y una distancia de trabajo de 150 mm y captura imágenes con una resolución de 640x480 pixeles. El sensor magnético

funciona como un potenciómetro cuyo valor de resistencia está relacionado con el valor de la posición, este puede adherirse a la

pieza bajo medición, la lectura del sensor magnético se realiza mediante un módulo Bluetooth. El odómetro se coloca en forma

paralela a la cámara y se desplaza en dirección al eje óptico de la cámara. Nuestra configuración del sistema está diseñado para una

distancia óptima de 150 mm de profundidad. La principal aportación de este trabajo está centrada en el módulo de posicionamiento del

sistema de dimensionamiento. La contribución de este módulo es la adaptación de un sistema de visión junto con la integración de

sensores de desplazamiento lineal de bajo costo y fácil adaptación; un sensor magnético y un odómetro que es desarrollado por

nosotros, para calcular el posicionamiento del sistema. En particular, el enfoque consiste en fusionar las mediciones provenientes

de los sensores con el fin de lograr estimaciones del posicionamiento del sistema más exactas, el cálculo de la posición es formulada utilizando técnicas de estimación como los filtros FK y FP que modelan el comportamiento lineal del sistema, ambos métodos

han sido implementados con el propósito de reducir el error de la estimación resultante. La novedad de este trabajo es el desarrollo

de un método de posicionamiento para el sistema de visión activa para la mejora del dimensionamiento de objetos.

2. Estado del arte

El sistema de escaneo tridimensional presentado está compuesto por un módulo de dimensionamiento de visión activa y un módulo de posicionamiento. El módulo de visión activa consta de un fibroscopio y un generador de luz. El módulo de posicionamiento está formado por un sistema de visión, un sensor magnético y un odómetro. La aplicación del sistema de medición se basa en la determinación de la profundidad del sistema de dimensionamiento 2D de visión activa, para poder dimensionar el interior del objeto con este sistema, cada componente ó todo el sistema de visión debe ser calibrado. Son pocos los artículos que especifican métodos particulares para calibrar una cámara conectada a un fibroscopio utilizada como parte del sistema de escaneo y que proponen un sistema de posicionamiento de luz activa con varios sensores para el dimensionamiento de objetos, en esta sección presentamos algunos trabajos comparativos con el presente trabajo.

2.1 Visión Activa

Los artículos que describen la calibración de la cámara conectada al ocular de un endoscopio los podemos dividir en dos grupos: los que se basan en la técnica propuesta por [1] como [2,3,4], y los que realizan la calibración considerando una lente de pescado (lente fish-eye) con un ángulo de visión superior a los 45 grados como los propuestos por [5,6,7,8]. El trabajo presentado por [9] consta de un sistema catadióptrico formado por un endoscopio y un espejo esférico. Los autores calibran el sistema de dos formas: usando el modelo pinhole presentado en [1] donde la distorsión radial modela la curvatura del espejo y proponen un modelo propio para el sistema.

Varias de las publicaciones para el escaneo 3D de piezas huecas utilizando endoscopios rígidos o flexibles se encuentran en el campo de la medicina, por ejemplo [10-19] utilizan piezas de referencia para validar los escaneos 3D en el interior del cuerpo humano, por lo que bien pudieran ser utilizadas en el sector industrial. Los trabajos que utilizan endoscopios rígidos o flexibles para escaneos 3D de utilidad en la industria son: [20,21,22,23,24,25]. En [20] se desarrolló un robot para inspeccionar tuberías con diámetros entre 20 cm y 50 cm, su sistema emite luz estructurada para escanear tridimensionalmente el interior de las tuberías. En [21] se menciona que la mayoría de los trabajos dedicados a escaneos 3D a través de endoscopios han sido enfocados a patentes, el método de calibración de la cámara descrito es similar a nuestro trabajo, incluso la manera de comprobar la exactitud del sistema, ya que sigue la ideología de nuestro trabajo usando piezas de referencia. En [22] se utiliza un videoscopio y un escáner láser para realizar los escaneos 3D, la manera de comprobar la exactitud es con piezas de referencia y su trabajo está enfocado al área médica.

De acuerdo con [23], existen pocas publicaciones que describen el escaneo 3D de piezas huecas a partir de imágenes adquiridas con fibroscopios monoculares. Los trabajos [26,27], al igual que nosotros, utilizan un fibroscopio y escanean en 2D secciones transversales que luego posicionan mediante otro sistema. Sin embargo, [26,27] se basan en un enfoque de iluminación activa utilizando un espejo cónico para proyectar un rayo láser en forma de anillo sobre la superficie interior de la tráquea con el fin de encontrar estenosis. En el trabajo de [10] al igual que nosotros, proyectan un haz de luz para resaltar la superficie a medir, para ello utilizan un galvanómetro con el fin de resaltar diferentes zonas en el interior del órgano. Este trabajo encuentra también la relación angular entre la cámara y el láser con el fin de calcular coordenadas 3D. Para lograr el escaneo 3D, [16], proyecta un láser de color verde con el fin de triangular haciendo uso del láser y la cámara. [19] desarrolló su propio escáner endoscópico, su trabajo al igual que el nuestro proyecta uno o más anillos en el interior a escanear, con dichos anillos y una lente catadióptrica conectada a la cámara puede capturar puntos en 3D. En [23] el escaneo 3D es a partir de la extracción de puntos característicos de las imágenes y al igual que en este trabajo filtran las estructuras de panal de abeja para mejorar la calibración de la cámara y los escaneos 3D. [24] desarrollaron un sistema para inspeccionar barrenos que utiliza un endoscopio rígido y un proyector láser que proyecta un patrón circular. El sistema es guiado por un brazo robótico e inspecciona diámetros de barrenos entre 4 mm y 50 mm con una profundidad de 100 mm. [25] presentan una técnica conocida como Tomografía de Coherencia Óptica (OCT) para el escaneo 3D, también utilizaron un espejo cónico para la iluminación. Esta técnica no incluye componentes electro-mecánicos en la punta de la sonda. Dos revisiones que tratan el escaneo 3D utilizando endoscopios y análisis de imágenes tanto en el área médica como la industrial son presentados en [28,29]. Ninguna de estas revisiones presenta el diseño de un sistema de posicionamiento similar a nuestro trabajo, por lo que se puede considerar a nuestro sistema como innovador tomando en cuenta el sistema de iluminación propuesto, las metodologías para calibrar el sistema, la integración de los sensores y la forma de calcular el posicionamiento de la luz activa y evaluar los errores de medición y su incertidumbre, donde la principal aportación es el desarrollo del sistema de posicionamiento.

La Tabla 1 muestra las principales características que presenta nuestro sistema para escanear el interior de piezas comparado con otros sistemas. Los artículos presentados en esta tabla utilizan luz estructurada con uno o varios planos, o proyectan luz con formas conocidas. Los trabajos que no usan luz estructurada, [23], detectan características en la imagen que son seguidas mientras el sistema de visión calibrado se desplaza de manera controlada, usando el método de factorización las características seguidas son escaneadas tridimensionalmente. La mayoría de los trabajos usan una referencia con el propósito de transformar las unidades de pixeles a unidades métricas. Pocos son los trabajos que hacen un análisis del error y de las incertidumbres del sistema de medición.

| Ref. | A) | B) | C) | D) | E) | F) | G) |

| [26] | x | x | x | ||||

| [27] | x | x | |||||

| [10] | x | x | x | ||||

| [16] | x | x | x | ||||

| [19] | x | x | |||||

| [20] | x | x | x | ||||

| [21] | x | x | x | x | x | ||

| [22] | x | x | |||||

| [23] | x | x | |||||

| [24] | x | x | x | x | |||

| [25] | x | x | x | x | |||

| Nuestro trabajo | x | x | x | x | x | x | x |

A) Uso de luz estructurada, B) Uso endoscopio o fibroscopio, C) Uso de referencias, D) Aplicación Industrial, E) Cálculo POSE de luz, F) Cálculo del error e incertidumbre, G) Cálculo de profundidad.

2.2 Determinación de la profundidad

Existen en la literatura trabajos relacionados con la estimación de la posición basados en la visión y la integración de sensores. Algunos de los trabajos que utilizan sistemas de visión para calcular la posición de los objetos utilizando información proveniente de las imágenes capturadas por la cámara son [30-32]. Autores como [33] realizan una estimación de la posición utilizando un sistema de múltiples cámaras, la configuración de estos sistemas combinan las observaciones de todas las cámaras para calcular los parámetros de rotación y traslación del sistema a partir de una secuencia de imágenes. En [34] presentan un método que permite calcular los valores de la posición y rotación de la navegación de una cámara monocular, calculan directamente los parámetros de movimiento a partir de una serie de imágenes y estiman la precisión de los parámetros. El trabajo propuesto por [35] aborda el problema de localización utilizando la aplicación de un algoritmo de mapeo probabilístico y localización simultáneos (SLAM) utilizando una sola cámara. El algoritmo SLAM permite generar mapas probabilísticos del entorno dados los puntos de las proyecciones de la imagen; con los mapas obtenidos es posible generar trayectorias de navegación.

Otros trabajos utilizan múltiples sensores como láser, giroscopios, GPS, etc. Para obtener información del posicionamiento de un objeto y mejorar la estimación de la posición de este, que se basan en métodos probabilísticos para fusionar los datos de los sensores como el filtro de Kalman [36], mezcla de gaussianas [37], localización de markov para entornos dinámicos como [38], etc. En el trabajo de [39] se describe la implementación de algoritmos de navegación para determinar la posición de un robot móvil a partir de la estimación del odómetro cuando este se mueve en un entorno conocido, donde muestran la integración de odómetros en aplicaciones de robótica móvil, el robot puede rotar y trasladarse a través del entorno y a su vez medir estos movimientos para su localización. Otro sistema de localización de un robot móvil en un ambiente estructurado es el desarrollado por [40] su sistema combina un sistema de visión omnidirecional junto con un odómetro, calculan una estimación fiable de la posición debido a que realiza un ajuste en las mediciones al combinar los datos de los sensores utilizando un método de filtrado estadístico (EKF). En [41], plantean el problema de la localización y control de posición de un robot móvil mediante el uso de sensores y la fusión de datos obtenidos de estos sensores, primero son corregidos los datos obtenidos por los odómetros del robot y después retroalimentan el EKF para tener mayor control de la posición. Otro enfoque para resolver el problema de localización de un objeto es el trabajo presentado por [42] donde se utiliza un sistema de detección de posición lineal, utilizando una serie de sensores magneto resistivos (MR) y señales de acondicionamiento electrónico. Los sensores se utilizan para determinar la posición de un imán que está unido a un objeto en movimiento, estos sensores miden la relación de la posición del imán y la función del campo magnético para determinar la posición del objeto [43], en este trabajo se describe un nuevo sensor de desplazamiento magnético que mide la posición de un imán a lo largo de dos ejes. El cálculo de la posición se consigue midiendo la dirección del campo magnético. Los sensores utilizados en este trabajo son dos circuitos de montaje superficial, a diferencia del sensor que utilizamos en nuestro trabajo que es un sensor magnético de película delgada. En [44] se expone la implementación de un algoritmo de detección y seguimiento de objetos mediante un escáner láser, su sistema funciona a partir de la segmentación de los datos del sensor que permite determinar el número de objetos presentes en el entorno y determinar sus movimientos para poder llevar a cabo una navegación de forma segura. Otros autores como [45] describen la auto localización de un robot utilizando las mediciones de un sensor ultrasónico basado en el filtro de partículas, los autores introducen varios métodos de localización para eliminar el ruido del proceso y de la medición, muestran resultados comparativos entre el filtro EKF y FP para la localización del robot con ambos métodos.

En [46] proponen un método de localización de un objeto en movimiento a través de una secuencia de imágenes tomadas por una cámara, utiliza el filtro de partículas como algoritmo de seguimiento basado en la información de múltiples sensores, integran un sistema de visión junto con un sistema de control para seguir de forma continua el objeto. Al igual que autores como [47] que proponen un método de seguimiento objetos basado en el control de movimiento de una cámara utilizan el filtro de partículas para predecir la posición del objeto en movimiento correspondiente a la información obtenida de una imagen. Autores como [48] analizan el problema entre la detección de un objeto y la estimación de la profundidad y realizan un seguimiento del objeto usando filtro de partículas, donde la posición de este objeto es modelado para la estimación de la profundidad. En [49] los autores presentan el seguimiento de un objeto en una secuencia de video, en sustitución de un modelo dinámico del objeto utilizan el método de substracción de fondo para predecir las ubicaciones del objeto y la aplicación del filtro de partículas para el seguimiento del objeto. En este trabajo presentamos el desarrollo de algoritmos para dar una solución al problema de la estimación de la posición, para mejorar el dimensionamiento 2D del interior del objeto a escanear.

3. Metodología

En esta sección se presenta un sistema capaz de escanear el interior de objetos en dos etapas. La primer etapa realiza el dimensionamiento 2D de una sección transversal usando visión activa. La segunda etapa localiza el sistema de visión activa dentro del interior del objeto para asignarle al dimensionamiento 2D el valor de profundidad que corresponde a la posición de la luz activa.

El sistema cuenta con una cámara CCD monocromática (C1) con una resolución de 24482046 pixeles y un sensor de 1/1.45" que se conecta al ocular del fibroscopio utilizando un video acoplador óptico (VA) (Figura 2). Un fibroscopio de 7 mm de diámetro (FIBRO) con una longitud efectiva de 1320 mm, dispone de una distancia mínima de trabajo de 30.48 mm, y un campo de visión de aproximadamente 50 grados alrededor del eje vertical y 40 grados alrededor del eje horizontal. La configuración del sistema del sistema de medición propuesto se muestra en la Figura 3.

La Figura 4 muestra la cámara endoscópica (mC2), que utiliza tecnología optoelectrónica para inspeccionar áreas de difícil acceso.

La cámara endoscópica (mC2) tiene un diámetro de 7 mm, las dimensiones son de 510.54 mm 7.62 mm 7.62 mm, la resolución es de

640x480 pixeles (JPEG), adquiere a 30 cuadros por segundo (FPS) y usa una luz LED ajustable en la punta de la cámara para iluminar

la zona de inspección. En la punta del fibroscopio se adjuntó un dispositivo de iluminación, omitiendo el sistema de iluminación

proporcionado por el fibroscopio. Este dispositivo está formado por un LED de potencia de color rojo de 1 watt (LP) y dos placas

rectangulares opacas unidas a la circunferencia del LED. Las placas rectangulares se colocan de tal manera que el componente emisor

de luz del diodo está entre las placas (véase región del LP ampliada que muestra el LED entre placas sujetas al fibroscopio). De

esta manera, la luz sólo puede salir a través de la ranura formada por las placas, formando un plano de iluminación que toma la

forma de la sección transversal del interior donde se proyecte. Las placas tienen un patrón de círculos impresos, que junto con la

cámara 2 (mC2) localizan el plano de luz al interior del objeto.

|

| Figura 4. Cámara Endoscopica USB Super Eyes N005 |

Otro sistema de posicionamiento usado es un sistema llamado magneto-pot o escala magnética (ME), que es un potenciómetro con una

resistencia variable, su operación se fundamenta en la variación de la resistencia en función de la posición. La ME puede adherirse

a la pieza bajo medición. La lectura de posición de la ME y el control de intensidad del LP se realizan mediante un módulo Bluetooth

(BT). Una interfaz gráfica de usuario (PC) es utilizada para controlar y leer todos los dispositivos del sistema y procesar la

información necesaria para realizar el escaneo 3D. Un tercer método para calcular el posicionamiento de las secciones transversales

es utilizando un odómetro (ODO), el cual calcula el desplazamiento del LP uniendo la cuerda del odómetro a una de las placas del LP.

3.1 Visión Activa

El diagrama de flujo de la Figura 5 muestra la metodología para realizar el dimensionamiento o escaneo 2D. En él se muestran tres grandes bloques de operaciones delimitados con línea punteada. Procedimiento de calibración, trazabilidad, posición y orientación (POSE).

|

| Figura 5. Diagrama de flujo para el escaneo 2D del interior de piezas huecas |

El procedimiento de calibración que se muestra en el bloque superior calcula los parámetros intrínsecos de la cámara conectada al

fibroscopio y los coeficientes de distorsión de la lente acoplada a la cámara. Los parámetros y los coeficientes son evaluados con

el toolbox de Bouguet et al. [50] modificado para detectar círculos. El bloque de trazabilidad permite encontrar la POSE del plano

de luz generado por el LED de potencia encerrado entre placas y la POSE de los anillos patrón, ambas POSEs respecto al sistema de

coordenadas de referencia ubicado en la cámara. Los anillos proporcionan la trazabilidad y corrección de la POSE del plano de luz.

El último bloque del diagrama describe como el contorno de las secciones transversales 2D definidas en el plano imagen, se

transforma en una nube de puntos (coordenadas 2D en el mundo) utilizando los parámetros intrínsecos de la cámara y la POSE del plano

de luz. Cada uno de los bloques mostrados en la Figura 5 se encuentra descritos en [3].

3.2 Determinación de la profundidad

Para calcular la profundidad se usó un sistema de visión, un odómetro y un sensor magnético. Primeramente determinamos el modelo del sensor, después hicimos una corrección, la caracterización del sensor (Figura 6) y finalmente la fusión de los datos obtenidos por los sensores.

|

| Figura 6. Modelado, corrección y caracterización de los sensores para el cálculo de profundidad |

El sistema de visión utilizado consta de una cámara y un patrón de referencia pegado en una de las placas del LED de potencia. El

modelo de la cámara usado es el pinhole. Para calcular los parámetros de la cámara usamos un patrón de calibración con círculos

impresos. En la caracterización, el patrón se mueve respecto a la cámara en intervalos de 10 mm usando un sistema de

posicionamiento calibrado, por ejemplo una Máquina de Medición por Coordenadas (CMM), el sistema es capaz de medir hasta una

distancia de 150 mm. Se toman tres secuencias de medición para caracterizar el sistema de visión.

Con el propósito de dar trazabilidad a los parámetros del modelo, se utiliza un patrón de calibración compuesto por una matriz de 8 x 8 círculos. La posición de cada centro del círculo es calculado por una Máquina de Medición de Coordenadas Ópticas (OCMM). Con este procedimiento extra, eliminamos los errores que puede introducir la impresora que imprime el patrón de círculos. Se modificó el toolbox de Bouguet [51] para utilizar los círculos en el cálculo de los parámetros intrínsecos.

El odómetro es un sistema que está compuesto por un conjunto de tarjetas electrónicas STM 32F4 discovery que se encargan de adquirir y procesar la señal de los pulsos generados (Figura 7). Entre las partes que componen el sistema se encuentra un módulo de medición lineal. El módulo lineal usa un encoder opto-electrónico con un carrete acoplado al mismo, se jala un cable por un sistema dentado con una cadena en la que cada vuelta el encoder hace un conteo de los pulsos generados. El conteo de los pulsos generados por el encoder relaciona las vueltas y el desplazamiento lineal de la cuerda que está sujeta al generador de luz estructurada. El modelo utilizado para el odómetro es un polinomio. Para calcular la corrección del polinomio usamos una Máquina de Medición de Coordenadas (CMM) y la metodología presentada en [52] para una sola dimensión. La caracterización del sensor se hizo de forma estadística aproximando la medición de los sensores a una distribución paramétrica normal.

| |

| (a) Odómetro completo | |

| |

| (b) Tarjeta STM 32F4 discovery que permite la lectura del odómetro y la interfaz de los datos | |

| Figura 7. Sensor odométrico | |

El sensor magnético (Figura 8) está formado por un imán de posición sobre un eje de movimiento del dispositivo. El sistema de

medición propone el uso de una escala magnética que funciona como un potenciómetro con una resistencia de 10K cuyo desplazamiento

depende de las posiciones del imán, para calcular el desplazamiento lineal al hacer presión sobre la capa superior del sensor, un

segundo imán se coloca sobre las placas del generador de luz (LP), lo que permite conocer el desplazamiento del sistema de luz

activa. El modelo utilizado para el sensor magnético es un polinomio. Para la corrección del polinomio usamos una Máquina de

Medición de Coordenadas (CMM) como en [52]. La caracterización del sensor de desplazamiento magnético se hizo de forma estadística

considerando una distribución normal.

|

| Figura 8. Arriba: Módulo bluetooth. Abajo: Escala magnética |

3.2.1 Modelo probabilístico del sistema

Sea una variable que toma como posibles valores , , que representan donde se encuentra posicionada la luz activa en un instante de tiempo , donde a cada valor de la variable se le asocia un valor de probabilidad, entonces para el conjunto de valores de junto con sus probabilidades se define la distribución de probabilidad como:

|

|

(1) |

Si es la localización del sistema en el instante actual , dadas una secuencia de observaciones medidas por los tres sensores , entonces para calcular la posición del sistema en el instante actual a partir de cierta medida se define un valor de probabilidad condicionada a todos los datos de los sensores disponibles mediante :

|

|

(2) |

El problema general es estimar la posición del generador de luz activa con el sistema propuesto. Las mediciones del sistema son datos con incertidumbres que se pueden modelar mediante distribuciones de probabilidad (PDF), en este caso como una distribución gaussiana. La ecuación (3) describe la probabilidad de que el generador de luz activa se encuentre en la posición medida por el sensor [53]

|

|

(3) |

donde es el dato medido por el sensor (sistema de visión, odómetro y magneto), es la media y es la desviación estándar de la distribución para la medición del sensor. Las PDF's resultantes para cada se utilizan para representar cada una de las mediciones de los sensores con sus incertidumbres, cada medición produce una distribución gaussiana de la posición del generador de la luz activa. Para cada sensor la media y la desviación estándar han sido calculadas para posiciones discretas, el desplazamiento de referencia de la luz activa fue hecho con la Máquina de Medición de Coordenadas (CMM). Los datos son interpolados para posiciones donde no se conoce la media y desviación estándar de referencia. Existen diferentes métodos para la interpolación de los datos, en este trabajo utilizamos el algoritmo de maximización de la esperanza (expectation-maximization, EM). La interpolación lineal de los datos está definida por [54]:

|

|

(4) |

|

|

(5) |

donde , corresponde a la media y desviación estándar para las posiciones desplazadas por la Máquina de Medición de Coordenadas (CMM), y los datos estadísticos interpolados, es el parámetro de interpolación, indica la diferencia entre dos valores observados, dadas dos muestras aleatorias , la es la varianza de , variable aleatoria unidimensional .

3.2.2 Fusión de sensores

La alineación de los sensores es importante ya que la posición inicial del sistema se estima con esta referencia. Los datos obtenidos de los sensores son fusionados para mejorar la estimación de la posición del generador de luz activa (Figura 9). El odómetro y magneto adquieren datos los cuales son corregidos usando una curva polinómica previamente calculada. Las imágenes de la cámara son corregidas en cuanto la distorsión radial usando los coeficientes de distorsión.

|

| Figura 9. Metodología utilizada para el cálculo de la profundidad |

Usando la CMM, el sistema de dimensionamiento activo se desplazó varias veces a diferentes posiciones y se caracterizaron los datos

de los sensores a diferentes posiciones de la CMM. Estas posiciones de la CMM son discretas, cuando una posición del sensor no ha

sido caracterizada se usa la interpolación descrita en la Sección 3.2.1.

El siguiente paso será el de fusionar todos los sensores. Cuando se tienen datos de diferentes sensores lo conveniente es realizar una fusión de datos con el fin de disminuir el error en la estimación de la posición, la idea de la fusión de dos o más datos es combinar las PDF's de estas mediciones para obtener un solo conjunto de datos. Las correspondientes distribuciones se fusionan mediante la multiplicación de las PDF's dada la ecuación 6, que representa la multiplicación de los datos y esta definida como la distribución de probabilidad conjunta

|

|

(6) |

De la resultante de la combinación de las PDF de cada sensor, extraemos los datos del valor esperado o media, , que representa la mejor estimación de la posición y la desviación estándar que es la incertidumbre asociada al valor esperado de la posición [55]. Entonces, la posición estimada de la luz activa es corregida mediante la fusión de estas distribuciones de probabilidad.

3.3 Estimadores de posición

Los filtros de Kalman y Partículas son algoritmos que actualizan recursivamente una estimación del estado del sistema de visión activa dada una secuencia de observaciones. Utilizamos la aplicación de ambos filtros como estimadores del posicionamiento del sistema de dimensionamiento basado en luz activa para tener un mayor control de la medición de la posición. Ambos filtros comienzan con una representación del modelo dinámico del sistema, el filtro de Kalman estima la posición en base a retroalimentación del modelo lineal del sistema, mientras que el filtro de partículas lo hace en términos de la predicción de muestras aleatorias, la idea principal es representar la distribución de la posición del sistema. El modelo dinámico del sistema que describe el comportamiento del sistema es presentado por:

|

|

(7) |

con una medida:

|

|

(8) |

donde es el vector de estado que describe la posición del sistema, representa el error de la estimación del estado, es el error aleatorio asociado a las mediciones de los sensores y es la medición conocida dada por el sistema en la posición actual. y son constantes iguales a 1 debido a que nuestro sistema de posicionamiento se mueve sobre un solo eje. El objetivo es dar una solución al problema de la estimación de la posición de la luz activa aplicando los algoritmos propuestos el FK y FP para estimar el vector de estado dado un conjunto de mediciones provenientes del sistema de medición, así, los filtros procesan las mediciones sobre un conjunto de muestras, dando finalmente como resultado el valor estimado .

3.3.1 Filtro de Kalman

El Filtro de Kalman(FK) se utiliza para modelar sistemas lineales en el que las mediciones del sistema se ven afectadas por ruido aleatorio provenientes del comportamiento del sistema. Para hacer una estimación de los valores de la posición, el filtro requiere de los valores estadísticos del ruido del proceso y de las mediciones, las cuales son utilizados para la estimación de la posición de la luz activa para producir estimaciones que están mas cerca del valor real, a partir de las mediciones obtenidas de la mezcla de gaussianas se obtiene un vector de medición , estas mediciones son utilizadas para inicializar el filtro.